"Vì sao AI nguy hiểm?"

Tỷ phú Elon Musk và nhóm hơn 1.000 (nay đã đạt con số hơn 3.000) chuyên gia công nghệ hàng đầu đã khởi động quá trình ký một bức thư ngỏ gửi Liên hiệp quốc cảnh báo về nguy cơ trí tuệ nhân tạo (AI) phát triển không kiểm soát. Câu hỏi đặt ra là “Vì sao AI nguy hiểm với con người”?

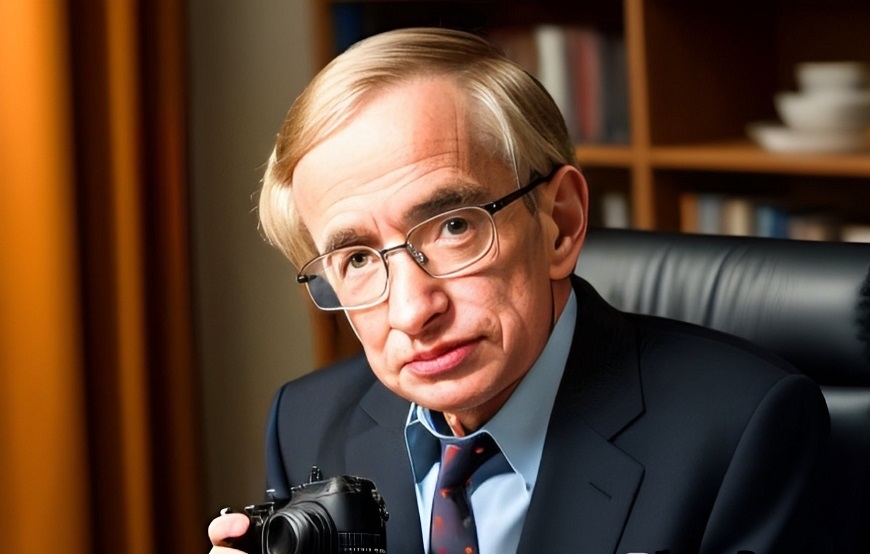

Trên thực tế đây không phải lần đầu tiên các nhà khoa học lên tiếng cảnh báo về viễn cảnh trí tuệ nhân tạo trở nên nguy hiểm đối với con người. Năm 2014, nhà vật lý lý thuyết nổi tiếng người Anh Stephen Hawking cho rằng: “Sự phát triển toàn diện của trí tuệ nhân tạo có thể sẽ hủy diệt loài người”. Ông cũng nhận định loài người sẽ bị trí tuệ nhân tạo hoàn toàn thay thế trong 500 năm nữa nếu không cẩn trọng trong quá trình nghiên cứu và phát triển công nghệ nguy hiểm này.

Cách đây 8 năm, tháng 7-2015, hơn 1.000 chuyên gia nghiên cứu công nghệ trí tuệ nhân tạo, trong đó có Stephen Hawking, Elon Musk, Noam Chomsky… đã cùng ký vào một lá đơn cảnh báo về nguy cơ một cuộc chạy đua vũ trang trong lĩnh vực AI quân sự và kêu gọi cấm toàn diện các loại vũ khí tấn công tự động (autonomous weapons: Kết hợp AI và vũ khí sát thương). Việc OpenAI cho ra mắt ứng dụng Chat GPT vào tháng 11-2022 đã thêm một hồi chuông cảnh báo đối với nguy cơ hiện hữu từ trí tuệ nhân tạo. Trên thực tế, những gì Chat GPT đang làm cho thấy AI ở chừng một mực nào đó đã và đang trở nên nguy hiểm hơn rất nhiều so với những gì con người từng nghĩ.

|

| Nhà vật lý lý thuyết Stephen Hawking qua lăng kính AI. Ảnh: AI vẽ theo ý tưởng của tác giả |

Nguy cơ tiềm ẩn của trí tuệ nhân tạo phụ thuộc vào cách mà nó được sử dụng. Ban đầu AI được phát triển để trợ giúp con người trong công việc, đặc biệt là với các công việc nhàm chán lặp đi lặp lại như phân loại hình ảnh, rà soát thông tin... Tuy nhiên, với sự phát triển nhanh chóng của AI trong thời gian gần đây, các nhà khoa học và chuyên gia công nghệ lo ngại rằng nếu phát triển một cách không kiểm soát, hoặc được lập trình với mục đích không đúng đắn, trí tuệ nhân tạo có thể gây ra những hậu quả nghiêm trọng cho con người và xã hội.

Nguy cơ mất an ninh

Trí tuệ nhân tạo có thể trở thành mối nguy đối với an ninh quốc gia và an toàn cá nhân. Elon Musk đã cảnh báo rằng AI có thể trở thành một công cụ đáng sợ trong chiến tranh. Nếu một quốc gia có thể phát triển một hệ thống trí tuệ nhân tạo vượt trội, quốc gia đó có thể sử dụng nó để tấn công các quốc gia khác. Giáo sư khoa học máy tính Stuart Russell tại Đại học California là người từng dành hàng chục năm nghiên cứu về trí tuệ nhân tạo. Cảnh báo về mối hiểm họa đối với an ninh do AI mang lại, ông cho rằng hiện nay chúng ta đã có thể sản xuất vũ khí tấn công tự động bằng cách tích hợp và thu nhỏ những công nghệ sẵn có.

Thí nghiệm được Giáo sư Stuart Russell cùng Viện nghiên cứu Cuộc sống tương lai (FLI) tiến hành sử dụng một robot sát thủ (slaughterbot) là thiết bị bay siêu nhỏ, trang bị camera, cảm biến, phần mềm xử lý hình ảnh, nhận diện khuôn mặt, một khối thuốc nổ nặng 3gr, và một bộ vi xử lý tốc độ cao, cho phép phân tích dữ liệu và phản ứng nhanh hơn 100 lần tốc độ bộ não con người. Theo thông số lập trình, robot sát thủ truy cập liên tục vào dữ liệu đám mây để tìm kiếm thông tin về mục tiêu và tìm cách tiếp cận. Khi đã tìm được, nó sẽ lao thẳng vào mục tiêu với vận tốc lớn, kích hoạt khối thuốc nổ 3gr, khoan sâu vào bên trong hộp sọ, giết chết nạn nhân trong nháy mắt.

|

| Nếu một quốc gia có thể phát triển một hệ thống trí tuệ nhân tạo vượt trội, quốc gia đó có thể sử dụng nó để tấn công các quốc gia khác. Ảnh: AI vẽ theo ý tưởng của tác giả |

Đó chỉ là một thí nghiệm với AI ở cấp độ đơn giản nhất. Nếu AI được sử dụng để phát triển các phương thức tấn công mới, tinh vi hơn, nó cũng có thể làm tăng khả năng tấn công của nhóm những kẻ tấn công và dẫn đến các hậu quả nghiêm trọng hơn so với các cuộc tấn công thông thường. Khi AI được phát triển đến trình độ có thể tự ra quyết định để đối phó với sự biến đổi của môi trường xung quanh hoặc tự tìm kiếm mục tiêu thay thế, hay mở rộng phạm vi mục tiêu thì có lẽ loài người sẽ không còn an toàn nữa. Rất nhiều đồng nghiệp trong lĩnh vực này đồng ý với Giáo sư Stuart Russell và cho rằng vẫn còn có cơ hội để ngăn chặn một tương lai ảm đạm như vậy, nhưng chúng ta cũng không thực sự còn nhiều thời gian.

Nguy cơ AI trở thành có tổ chức, tự làm chủ và kiểm soát hệ thống

AI có thể được thiết kế sai lệch hoặc được “huấn luyện” (training) thông qua cơ chế học máy (machine learning) không đúng cách và có thể thực hiện những hành động không mong muốn, gây thiệt hại cho con người và môi trường. Ví dụ cụ thể như sau: Với cơ chế học máy, AI ngày càng trở nên thông minh hơn. Khi trí tuệ nhân tạo đạt mức độ thông minh mà từ chỗ hỗ trợ các hệ thống quan trọng như điện lực, giao thông, y tế, tài chính..., nó có thể làm chủ và kiểm soát toàn bộ các hệ thống này và tự ra quyết định, thực hiện các quyết định đó trong các tình huống khẩn cấp. Khi AI được “trang bị” thêm các mục đích mang tính “dã tâm” có chủ đích (thiết kế sai lệch), nó có thể gây ra nhiều hậu quả nghiêm trọng như làm rối loạn hệ thống giao thông khi vô hiệu hóa hệ thống đèn giao thông hay ngắt điện hệ thống vận hành tàu điện đô thị, gây tai nạn liên hoàn, làm mất điện trên diện rộng...

Đã có khá nhiều bộ phim Hollywood và của nhiều nước được xây dựng theo kịch bản này. Tuy nhiên, với công nghệ AI hiện nay, điều này không còn là viễn cảnh quá xa xôi mà hoàn toàn có thể trở thành hiện thực. Elon Musk tin rằng nếu để AI phát triển không kiểm soát, đến mức nó có thể tự động hóa các quyết định mà không cần sự can thiệp của con người thì đây có thể là một nguy cơ cho sự tồn vong của con người. Đó là lý do ông cùng hàng nghìn chuyên gia công nghệ ký vào bức thư yêu cầu tạm ngừng và kiểm soát chặt chẽ quá trình phát triển AI một cách minh bạch.

Theo Elon Musk, các hệ thống trí tuệ nhân tạo rất phức tạp, khó hiểu và việc kiểm soát chúng là rất khó khăn. Nếu thiếu đi sự minh bạch, việc sử dụng trí tuệ nhân tạo cho các mục đích thiếu đạo đức, gây thiệt hại cho con người chắc chắn sẽ xảy ra.

Trí tuệ nhân tạo có thể phát triển đến mức có thể làm chủ các hệ thống, tự ra quyết định, và như vậy có thể gây hậu quả nghiêm trọng nếu vượt ngoài tầm kiểm soát của con người. Ảnh: AI vẽ theo ý tưởng của tác giả

|

| Trí tuệ nhân tạo có thể phát triển đến mức có thể làm chủ các hệ thống, tự ra quyết định, và như vậy có thể gây hậu quả nghiêm trọng nếu vượt ngoài tầm kiểm soát của con người. Ảnh: AI vẽ theo ý tưởng của tác giả |

Nguy cơ tước đoạt việc làm, vi phạm quyền riêng tư

Khi được sử dụng để thu thập thông tin cá nhân, công nghệ trí tuệ nhân tạo có thể bị sử dụng để vi phạm quyền riêng tư, thực hiện các hoạt động truyền thông thất thiệt, tuyên truyền thông tin sai lệch ảnh hưởng tới tình hình xã hội và ổn định chính trị. Vụ việc hệ thống mạng của Văn phòng Quản lý nhân sự (OPM) chính phủ Mỹ bị tấn công bởi tin tặc đã là đáng lưu tâm đối với bất cứ quốc gia hay tổ chức nào khi dữ liệu cá nhân chi tiết và rất nhạy cảm của 21,5 triệu quan chức tại chức và đã nghỉ hưu của Mỹ, thông tin về vợ/chồng của họ, dữ liệu về những người từng nộp đơn xin việc vào cơ quan chính phủ như tình trạng sức khỏe, nơi cư trú, công việc, vân tay và thông tin tài chính đã lọt vào tay tin tặc.

Thế nhưng có một thực tế còn đáng sợ hơn khi CIA phát hiện ra rằng đối tượng đánh cắp dữ liệu OPM đã sử dụng công nghệ trí tuệ nhân tạo để rà soát, fake (làm giả) thông tin cá nhân, tạo lập các điệp viên ảo để đánh cắp dữ liệu. Thông tin sau khi bị đánh cắp sẽ được công nghệ Bigdata (dữ liệu lớn) phân tích, phân loại, và khai thác cho các mục đích sử dụng cụ thể. Công nghệ trí tuệ nhân tạo giúp bên đánh cắp thông tin rút ngắn được thời gian khai thác thông tin bởi con người không đủ khả năng xử lý một khối lượng thông tin khổng lồ trong một thời gian ngắn như vậy.

Bên cạnh những mối nguy hiện hữu nói trên, công nghệ AI cũng tạo ra những nguy cơ khác như: Phụ thuộc quá mức vào nó, dẫn đến hậu quả con người mất kiểm soát tình hình và suy giảm khả năng đưa ra quyết định. Trí tuệ nhân tạo cũng sẽ khiến hàng triệu, thậm chí hàng trăm triệu người mất việc làm, đặc biệt là đối với những công việc lao động chân tay thuần túy, ít hàm lượng tri thức. Hậu quả là những vấn đề xã hội nghiêm trọng như thất nghiệp, tội phạm, khoảng cách giàu - nghèo... sẽ càng trở nên sâu sắc hơn.

Thêm vào đó, độ tin cậy cũng là vấn đề cần nhắc đến. Độ tin cậy của các quyết định trong các lĩnh vực chuyên môn hóa cao như y tế, hình sự... là vô cùng quan trọng. Khi sử dụng AI để trợ giúp đưa ra các quyết định trong những lĩnh vực đó mà công nghệ không đủ tin cậy, vận hành dựa trên các dữ liệu có xu hướng thiên vị một hoặc một nhóm người hoặc bị bóp méo có chủ đích thì những quyết định đó có khả năng gây ra những hậu quả nghiêm trọng.

|

| Trí tuệ nhân tạo sẽ khiến hàng triệu, thậm chí hàng trăm triệu người sẽ mất việc, tạo bất ổn xã hội, gia tăng đói nghèo. Ảnh: AI vẽ theo ý tưởng của tác giả |

Ngăn chặn bằng cách nào?

Những nguy cơ nói trên là lý do khiến Elon Musk và các chuyên gia công nghệ lo ngại về sự phát triển không kiểm soát của AI và viết thư kêu gọi Liên hợp quốc và các tổ chức quốc tế kiểm soát chặt chẽ, đảm bảo an toàn và đạo đức trong phát triển AI; tăng cường hợp tác quốc tế để đảm bảo công nghệ AI được sử dụng có ích cho con người và xã hội. Một số biện pháp cụ thể có thể điểm mặt là:

- Kiểm soát độ tin cậy của hệ thống: AI cần được thiết kế và phát triển để đảm bảo tính an toàn và độ tin cậy thông qua các phương pháp kiểm tra chất lượng, kiểm soát, và giám sát chặt chẽ, thường xuyên, liên tục để đảm bảo hệ thống AI hoạt động theo mong muốn của con người và tránh những tác động không mong muốn từ độ thiếu tin cậy của nó.

- Công nghệ trí tuệ nhân tạo cần phải được lập trình để hoạt động theo các giá trị đạo đức và chuẩn mực xã hội. Các quy định và tiêu chuẩn đó cần phải được thiết lập một cách rõ ràng và phải được giám sát thực hiện để đảm bảo rằng chúng không làm bất kỳ việc gì xấu hay có hại cho con người hoặc tổ chức. Quy trình phân tích, đánh giá tác động và giám sát hoạt động của hệ thống AI cũng phải được thường xuyên thực hiện để đảm bảo hoạt động chuẩn mực, không vi phạm và làm xói mòn các giá trị chung của toàn xã hội, không gây ra tác động tiêu cực và đảm bảo truyền tải kiến thức và giá trị đúng đắn.

Báo chí là một trong những ngành bị ảnh hưởng nhiều bởi trí tuệ nhân tạo. Trong tương lai sẽ không cần MC đọc OFF cho các chương trình phát thanh, và thậm chí là MC ảo dẫn ON cho chương trình truyền hình sẽ chiếm ưu thế.

- Tạm dừng “huấn luyện” trong ít nhất 6 tháng đối với các hệ thống trí tuệ nhân tạo để đánh giá lại toàn bộ vấn đề. Việc tạm dừng này phải được công khai, có kiểm soát và tất cả các nhân tố chính liên quan đến việc đào tạo này đều phải thực hiện. Nếu cần thiết, các chính phủ cần ban hành lệnh cấm tạm thời. Điều này không có nghĩa là dừng phát triển AI hoàn toàn mà chỉ đơn thuần là một lần tạm dừng trong cuộc đua nguy hiểm để chuyển sang các mô hình phát triển khác, làm cho các hệ thống AI trở nên chính xác, an toàn, dễ hiểu, minh bạch, phù hợp, đáng tin cậy và trung thành hơn. Đây là một giải pháp tổng thể mà Elon Musk và các đồng nghiệp kêu gọi trong thư ngỏ nhưng tính khả thi là không cao. Rất khó để tất cả các phòng thí nghiệm độc lập tuân thủ một kêu gọi không có tính ràng buộc mà lại có tính xuyên quốc gia như vậy.

- Tăng cường hợp tác và chia sẻ thông tin giữa các quốc gia, tổ chức nghiên cứu AI độc lập để đảm bảo rằng AI được phát triển và sử dụng một cách an toàn trong tương lai. Hợp tác và chia sẻ thông tin cũng là biện pháp để kịp thời cảnh báo và ngăn chặn bất kỳ nguy cơ nào nổi lên trong tương lai.

Nói chung, AI đã và đang hiện hữu ở khắp mọi nơi quanh chúng ta và những câu chuyện như trí tuệ nhân tạo làm thơ, viết nhạc, viết báo đã trở thành hiện thực chứ không còn là điều viễn tưởng nữa. Bản thân tác giả bài viết này đã sử dụng công nghệ trí tuệ nhân tạo trên máy tính và điện thoại để trợ giúp, làm cho quá trình viết bài của mình thuận lợi hơn, nhanh chóng hơn. Cụ thể, đoạn sa-pô (chapeau) của bài viết này và một số ý tưởng là do AI gợi ý và đặc biệt hơn là toàn bộ những bức ảnh sử dụng trong bài viết này đều do AI tạo ra. Công nghệ trí tuệ nhân tạo rất hữu dụng trong cải thiện chất lượng công việc, cuộc sống của con người, nhưng nó cần phải được kiểm soát chặt chẽ để không vượt ra ngoài tầm kiểm soát và trở thành nguy cơ thay thế con người trong tương lai như dự báo của nhà vật lý lý thuyết Stephen Hawking.

Theo qdnd.vn

về đầu trang

về đầu trang